【希望之聲2023年9月10日】(本台記者謝伯壺綜合報導) 科研人員發現,一些論文中未披露使用人工智能,但仍然通過了同行評審,而這些論文中使用的人工智能工具是ChatGPT。

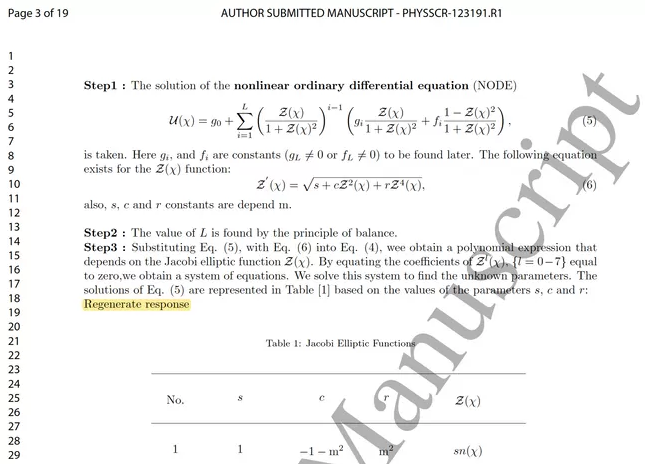

8月9日,《Physica Scripta》雜誌發表了一篇論文,旨在發現複雜數學方程的新解決方案。這似乎是真的,但科學偵探紀堯姆·卡巴納克(Guillaume Cabanac)在手稿的第3頁上發現了一個奇怪的短語:「再生反應」(Regenerate response)。

這個短語是ChatGPT上按鈕的標籤,它是一款免費使用的AI聊天機器人。當使用者詢問ChatGPT時,它就會生成流暢的內容。法國圖盧茲大學的計算機科學家卡巴納克(Cabanac)迅速在科學家討論已發表研究的網站PubPeer上,發佈了該頁面的截圖。

科學偵探紀堯姆·卡巴納克(Guillaume Cabanac)在手稿的第3頁上發現了一個奇怪的短語:「再生反應」(Regenerate response)(網絡截圖)

根據英國布里斯托爾(Bristol)《Physica Scripta》期刊的同行評審和研究誠信負責人金·艾格爾頓(Kim Eggleton)的說法,作者已經向期刊承認他們使用ChatGPT來幫忙撰寫論文。在兩個月的同行評審期間(論文於5月提交,並於7月發送修訂版本)或排版期間,沒有發現這一異常。

由於作者在提交論文時沒有聲明使用這一工具,期刊現在決定撤回該論文。艾格爾頓表示:「這違反了我們的道德政策。」

這並不是ChatGPT這個輔助工具在未經聲明的情況下,參與同行評審期刊的唯一案例。自今年四月以來,卡巴納克已經標記了十幾篇期刊文章,其中包含ChatGPT短語「再生回應」(該詞今年稍早已更改為「再生」)或「作為AI語言模型,我……」,並將它們發佈在PubPeer上。

許多出版商都表示,作者只要清楚聲明,就可以使用ChatGPT和其他大型語言模型(LLM)工具來幫助他們完成內容。

總部位於倫敦的英國研究誠信辦公室的研究誠信經理馬特·霍奇金森(Matt Hodgkinson)說,作者隱藏自己的論文是完全或部分由計算機軟件所撰寫的,這已不是甚麼新鮮事,但我們從中還是能發現微妙可檢測的痕跡。

霍奇金森認為,若研究人員把那些易分辨的ChatGPT短語刪除的話,那更複雜的聊天機器人所創造出來的內容「幾乎不可能」被發現。這本質上就像是一場軍備競賽——騙子與試圖將他們拒於門外的人。

加利福尼亞州舊金山市的微生物學家和獨立研究誠信顧問伊莉莎白·比克(Elisabeth Bik)表示,ChatGPT和其他生成性人工智能工具的迅速崛起,將為造紙廠提供助益。因為這些公司可以幫助希望提高出版產量的研究人員製作和銷售假手稿。

比克指出,這將使問題變得糟糕一百倍,也讓人擔心這些大量湧入,但人們已不再認識的論文。

霍奇金森說,ChatGPT和其他LLM會製造虛假的參考文獻,這可能是同行評審員希望在手稿中發現這些工具被運用的痕跡。

哥本哈根國家血清研究所的微生物學家魯恩·斯滕斯沃爾德(Rune Stensvold)就遇到過這種情況。

當時一名學生向他索要一篇論文的副本,該論文是斯滕斯沃爾德與他的一位同事在2006年合著的,但這篇論文實際上並不存在。這學生要求一個人工智能聊天機器人提出跟研究有關的論文,然後聊天機器人拼湊出了一份帶有斯滕斯沃爾德名字的參考文獻。

「它看起來很真實,」斯滕斯沃爾德說。「它教會了我,當我有論文要審查時,我可能應該從查看參考文獻部分開始。」

責任編輯:唐潔

本文章或節目經希望之聲編輯製作,轉載請註明希望之聲並包含原文標題及鏈接。